Informatique : vers un Nouveau Monde

- Les 5 moteurs du changement

- 1. L'évolution foudroyante des microprocesseurs et des systèmes de stockage

- 2. Le stockage des données multimédia : du tout-analogique au tout-numérique

- 3. Des réseaux spécialisés à l'Internet

- 4. De la programmation à l'assemblage d'objets et de composants logiciels.

- 5. Un dialogue naturel avec les machines ?

- L'âge de l'information

- Références bibliographiques

Cet article figure en Introduction du Traité sur l'Informatique

des Techniques de l'Ingénieur.

Cet article figure en Introduction du Traité sur l'Informatique

des Techniques de l'Ingénieur.

| " L'histoire de l'humanité s'accélère. Sur les quatre milliard d'années d'existence de notre planète,

toutes les espèces connues datent de moins de cent million d'années, l'homme de moins d'un million d'années, le plus ancien dessin sur la paroi

d'une caverne de 30 000 ans. Il y a tout juste 500 ans, l'invention de l'imprimerie accélérait la diffusion du savoir. 200 ans nous

séparent de la machine à vapeur qui provoqua la révolution industrielle.

Avec ses 50 ans, l'ordinateur fait figure de jeunot. Et pourtant

quelle comparaison possible entre le premier ordinateur (50 tonnes, 25

kilowatts, quelques milliers de positions de mémoire, une centaine

d'instructions par seconde) avec le microprocesseur Pentium

(quelques grammes, 25 watts, 32 Megaoctets de mémoire, 100 millions

d'instructions par seconde). Et tout laisse à penser que dans 10 ans le

Pentium apparaîtra aussi démodé que le premier ordinateur.

Lorsqu'il a été inventé, l'ordinateur était une curiosité de laboratoire. Au début des années 50, une étude de marché restée célèbre évaluait le marché mondial à une cinquantaine de machines. Aujourd'hui, les 200 millions d'ordinateurs installés démontrent qu'il serait inconcevable de s'en passer dans la civilisation industrielle contemporaine. Depuis 1995, il se vend dans le monde plus de P.C. que de téléviseurs. Pendant le temps mis à lire ce texte, le nombre d'ordinateurs connectés à l'Internet, le réseau des réseaux, a augmenté de plusieurs milliers. La manière dont l'informatique a révolutionné l'activité intellectuelle et économique n'a pas d'équivalent dans d'autres domaines. Une description purement statique des techniques et des résultats est donc totalement insuffisante pour comprendre l'informatique. Une vision dynamique s'appuyant sur les grandes tendances de l'évolution est indispensable pour comprendre ce qui va se passer même à très court terme." |

Lorsque j'écrivais ce texte publié en 1996, peu nombreux étaient ceux qui croyaient aux nouvelles technologies symbolisées par Internet. Et pourtant la nouvelle "société de l'information" annoncée dans ma conclusion s'est bien matérialisée si l'on en juge par les valorisations boursières atteintes au début 2000 par les sociétés de la "nouvelle économie". Les Technologies de l'Information sont maintenant intimement liées à notre manière de vivre et de travailler. Dans les dix prochaines années, le monde de l'informatique va subir des transformations profondes qu'il convient d'annoncer et de préparer.

Les 5 moteurs du changement

Il ne se passe pas de jours sans annonces de nouveaux produits matériels et logiciels tous plus performants les uns que les autres. Comment s'y retrouver et faire la part de ce qui attendu ou innovant dans une industrie où la performance des microprocesseurs double tous les 18 mois, celle des fibres optiques tous les 12 mois et celle des disques tous les 9 mois ? Comment prendre des décisions qui ne risqueront pas d'être remises en cause dans le mois qui suit ? En fait, l'Informatique est tirée par l'évolution de la technologie dans cinq domaines : le matériel, les bases de données, les réseaux, le développement du logiciel et l'interaction homme-machine.

- En premier, c'est les progrès continus des micro-processeurs et des systèmes de stockage qui permettent de fabriquer des équipements plus puissants et moins chers qui fixent le rythme de l'évolution de l'informatique. C'est ce que nous examinerons dans le chapitre sur l'évolution foudroyante des microprocesseurs et des systèmes de stockage.

- Cette performance bon marché permet de constituer des bases de données gigantesques. La numérisation des sons et des images rendue possible par les techniques de compression ouvre la voie aux données multimédia et à la gestion des connaissances. C'est le sujet du deuxième chapitre sur Le multimédia : du tout analogique au tout numérique.

- Le troisième chapitre sera consacré aux technologies et standards de l'Internet qui donnent naissance à des réseaux mondiaux de plusieurs dizaines de millions d'ordinateurs. Au début 2000, il y avait 1,57 milliard de pages accessibles sur le Web et ce nombre augmente de 3 millions par jour. C'est la partie la plus visible du développement des nouvelles technologies.

- La productivité et la fiabilité des développements logiciels progresse considérablement, même si cela est moins visible que dans le domaine du matériel. Ce sera le sujet du quatrième chapitre : De la programmation à l'assemblage d'objets et de composants logiciels.

- Enfin, l'interaction avec la machine doit devenir plus simple et plus intuitive et nous ferons le point dans le cinquième et dernier chapitre sur l'évolution de l'état de l'art avec l'introduction progressive des commandes tactiles et vocales qui rend le dialogue avec les machines plus naturel.

1. L'évolution foudroyante des microprocesseurs et des systèmes de stockage

C'est l'évolution de la technologie des composants qui depuis plus de 40 ans joue un rôle moteur primordial dans le développement de l'informatique. Deux phénomènes presque simultanés se sont produits vers la fin des années 40 : En 1945, l'invention par John von Neumann du calculateur à programme enregistré et, en 1948, l';invention du transistor par trois chercheurs des Bell Laboratories.

- En 1945, John von Neumann (1903-1957) inventait la forme moderne du programme enregistré. Vers 1840, le concept de programme avait déjà été introduit par Charles Babbage (1792-1871) comme élément d'une machine à calculer analytique qu'il se proposait de réaliser mais cette machine n'a jamais été construite. John von Neumann a introduit un raffinement important : écrire sous la même forme les instructions pour le traitement des données et les données elles-mêmes. Instructions et données étaient ainsi manipulées de la même manière par la machine ouvrant la voie à l'ordinateur moderne.

- Le transistor a été inventé en 1948 par John Bardeen, William Schockley et Walter Brattain, trois chercheurs des Bell Laboratories. A cette époque, le seul moyen connu d'amplifier un courant électrique était la lampe triode inventée en 1906 par Lee de Forest. La lampe triode avait permis le développement de la téléphonie et de la radio. C'était le composant majeur de tous les circuits électroniques. Cependant, la triode avait un gros défaut : son filament dont le chauffage consommait beaucoup d'énergie et dont la fragilité réduisait la durée de vie à quelques centaines d'heures. La fiabilité d'équipements de plusieurs centaines de lampes devenait intolérable. Par comparaison, le transistor consomme moins d' 1/10 000 000ème de l'énergie nécessaire à la triode avec une durée de vie quasiment illimitée.

La synergie entre un nouveau composant et une nouvelle application a provoqué une croissance explosive des deux. En effet, les systèmes numériques demandent un nombre très élevé de composants : une simple calculette a besoin de 100 fois plus de transistors qu'un téléviseur. Le microprocesseur Pentium comportait 7 millions de transistors. La mémoire RAM des P.C. en contient plusieurs centaines de millions. Avec un tel nombre de composants, le problème clé à résoudre a été celui du nombre et du coût des connexions.

Le coût de la connexion

De 10 francs sur un connecteur, ce coût passe à 1 franc sur une carte et tombe à un millionième de franc à l'intérieur d'un circuit intégré. Depuis le début des années 60, la stratégie des ingénieurs a donc été extrêmement simple : mettre le maximum de composants et de connexions dans un circuit intégré pour diminuer les coûts. En 1995, on sait mettre 7 millions de transistors dans un Pentium ce qui représente environ 18 millions de connexions. Par des méthodes traditionnelles, il aurait fallu 40 ans à un câbleur pour réaliser ces 18 millions de connexions. Par la miniaturisation et par l'intégration dans un seul circuit intégré, on obtient ce résultat pour quelques centaines de francs.

Le cercle vertueux du circuit intégré

La taille d'un circuit intégré a peu évolué. L'accroissement du nombre de composants est obtenu principalement par une réduction de la taille des gravures sur les circuits (moins de 0.2 micron en l'an 2000). Cette réduction entraîne deux conséquences sur les performances et sur les coûts :

- Les performances s'améliorent constamment. La vitesse maximum de fonctionnement d'un transistor dépend du temps de transit des électrons à l'intérieur du transistor. Plus l'intégration augmente, plus la taille des transistors diminue et plus les performances s'améliorent.

- Le coût marginal de production d'un circuit est à peu près constant (quelques dizaines de francs). La matière première, le silicium est disponible en abondance partout. Le prix unitaire d'un circuit est donc fixé par l'amortissement des études et de l'usine de fabrication. A performances constantes, le coût d'un microprocesseur ou de la mémoire est divisé par 10 tous les 4 ans.

A titre d'exemple au début des années 1980, le super ordinateur CRAY 1, capable de traiter 100 millions d'instructions par seconde était vendu 60 millions de francs. Il nécessitait une grande salle machine et des équipements de climatisation. En 1996, Un micro-ordinateur de cette puissance, à base de Pentium, avec la même capacité mémoire est la machine multimédia de base pour le grand public. Le prix est d'environ 10 000 francs soit 6000 fois moins que le CRAY 1. Ce micro-ordinateur fonctionne posé sur un bureau, sans précautions particulières.

Une évolution exponentielle

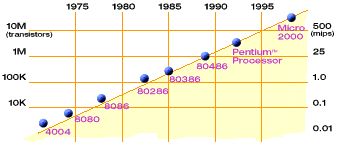

Le nombre de composants par circuit est passé, de manière très régulière, de quelques composants à la fin des années 50 à plusieurs millions aujourd'hui. Dès 1964, Gordon Moore, alors directeur de la recherche chez Fairchild avant de créer la société Intel en 1968, fût le premier à prédire que le nombre de composants par circuit continuerait à doubler tous les deux ans comme cela avait été le cas au cours des 5 années précédentes. Il n'y a pas eu depuis 35 ans de déviation significative par rapport à cette prédiction comme le montre la figure 1.

Figure 1. La performance des microprocesseurs double

tous les 18 mois

source Intel

Comme prévu, au début de l'an 2000 les microprocesseurs ont un cycle d'horloge qui dépasse le Giga hertz. Les premiers microprocesseurs Intel à 64 bits seront disponible au début 2001 sous le nom Itanium.

Vers le milliard de transistors par circuit ?

Quels sont les limites à cette intégration toujours plus poussée ? En fait, quel est le nombre maximum de composants qui pourront être intégrés dans un circuit ? Pour avoir une idée de ce nombre, il suffit de diviser la surface maximum d'un circuit intégré par la surface minimum d'un transistor.

- La surface d'un circuit intégré est un cristal de silicium pur. Compte tenu d'une probabilité raisonnable de ne pas avoir d'imperfections, cette surface maximum est d'environ 10 cm2. Cependant, cette surface ne peut pas être remplie entièrement avec des transistors. Il faut laisser la place pour des connexions. Aujourd'hui on constate que le taux moyen de remplissage est d';environ 10% ce qui nous donne donc 1 cm2 utile.

- La longueur minimum d'un transistor est d'environ 400 atomes de silicium. Ce chiffre est obtenu en tenant compte de la proportion d'impuretés à incorporer dans le cristal de silicium. Ce transistor doit être isolé de part et d'autre sur le circuit par une longueur équivalente. La distance entre 2 atomes de silicium est de 5.4x10-8. La longueur minimum du plus petit transistor est donc de 400x3x5.4x10-8 soit environ 10-4 cm de coté ce qui donne une surface de 10-8cm2.

Le nombre maximum obtenu par ce calcul simplifié est donc d'environ 100 millions de transistors par circuit. En fait, certains raffinements sont possibles ce qui porterait cette limite aux environs d'un milliard de transistors par circuit. En 1995, on sait intégrer 5 millions de transistors. Il reste un rapport 200 à gagner soit environ 10 ans au rythme actuel qui se ralentira sans doute un peu vers la fin. Le milliard de transistors par circuit sera atteint vers 2010. Cela veut dire que le processus d'intégration que nous connaissons depuis 35 ans va se poursuivre pendant encore au moins 10 ans. Tous les 18 mois, toutes choses étant égales par ailleurs, la puissance des microprocesseurs va continuer à doubler jusqu'en 2010.

Plus petit, plus vite et moins cher !

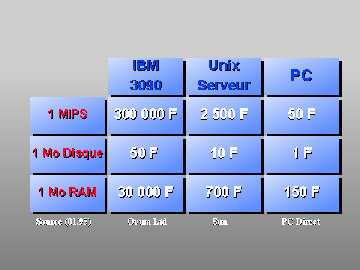

Figure 2 : Comparaison des prix des matériels

Les progrès continus réalisés depuis plus de trente cinq ans se traduisent dans le tableau de la figure 2. L'écart de prix considérable constaté pour «la même chose» n'est pas seulement lié à l'intégration des composants. Il reflète aussi l'amortissement des études sur des volumes beaucoup plus élevés rendus possibles par le remplacement progressif des systèmes dits «propriétaires» par des standards de fait mondiaux dits «systèmes ouverts». Dans le monde industriel, tout doublement du nombre d'unités produites entraîne une baisse des coûts de production de l'ordre de 20%. La concurrence entre les constructeurs différents qui fournissaient des systèmes complets incompatibles s'est progressivement transformée en une concurrence au niveau des composants sur les prix et les performances de systèmes interopérables. Le PC est donc devenu définitivement le calculateur universel le plus puissant et le moins cher de la planète avec ses 300 millions d'exemplaires en service.

Après 2010 ?

L'amélioration des performances des ordinateurs va donc se poursuivre au rythme exponentiel actuel pendant environ 10 ans. Au-delà de cette période le rythme du progrès, sans changer de technologie, se comparera à celui des autres technologies : quelques pour-cent par an. Pour améliorer le rapport performance prix de manière notable, il faudra trouver autre chose.

La première idée qui vient à l'esprit consiste à utiliser la lumière à la place de l'électricité, le photon à la place de l'électron. Un ordinateur à photons pourrait fonctionner au moins 1000 fois plus rapidement qu'un ordinateur à électrons. Cependant, nous ne savons pas encore amplifier la lumière sans passer par l'intermédiaire de l'électron. Il reste à inventer le «transistor à photons» pour espérer réaliser un jour des ordinateurs photoniques. Certains dispositifs existent et permettent d'espérer une solution mais comme il n'y a pas de piste très sérieuse pour une industrialisation, il est très probable que nous continuerons au-delà de l'an 2010 avec la technologie actuelle basée sur l'électron. L'ordinateur biologique reste un rêve d'auteur de science-fiction. Donc tôt ou tard, nous aurons besoin de puissance au-delà des capacités d'une seule machine.

La solution réside dans les architectures parallèles. Les calculateurs conventionnels exécutent les instructions de manière séquentielle. Dans les microprocesseurs performants, un parallélisme est introduit dans l'exécution des instructions. A l'insu du programmeur, le processeur de calcul effectue le maximum de traitements en parallèle en respectant la nature séquentielle du programme. Dans les systèmes multi micros, au contraire, le système se compose d'un réseau de calculateurs identiques capables de traiter des programmes différents en parallèle. Nous savons utiliser les systèmes parallèles lorsque le problème à résoudre s'y prête naturellement comme le calcul vectoriel ou les traitements sur les pixels d'une image. A part ces quelques cas particuliers, l'utilisation des multi micros dans les applications traditionnelles n'est pas évidente. Pourtant nous avons un excellent modèle à notre disposition : le cerveau humain. La vitesse de traitement des informations élémentaires dans le cerveau humain est très lente. L'information est transmise par une impulsion électrique à l'intérieur du neurone. Entre les neurones, ce sont des processus chimiques qui sont utilisés. La «vitesse de traitement» du cerveau est de quelques centaines de neurones par seconde. Cependant, ce cerveau est capable de réussir en moins d'une seconde des opérations extrêmement complexes par exemple la reconnaissance des visages. Les ordinateurs actuels parviennent péniblement à la reconnaissance des formes au prix de traitements informatiques très long. Nous sommes donc presque certains que le cerveau, composé d'environ 40 milliards de neurones reliés par une structure en réseau, utilise au maximum les traitements en parallèle. Cette analogie permet dimaginer lénorme réserve de puissance disponible lorsque nous saurons mieux utiliser les architectures parallèles.

2. Le stockage des données multimédia : du tout-analogique au tout-numérique

Le Multimédia est souvent présenté comme le fruit de la convergence annoncée des technologies de l'Informatique, des télécommunications et du monde des médias. L'histoire des sciences retiendra surtout qu'en cette fin de XXème siècle les informations traitées et stockées sont passées en moins de 30 ans d'une représentation «tout-analogique», propre à chaque média, au codage «tout-numérique».

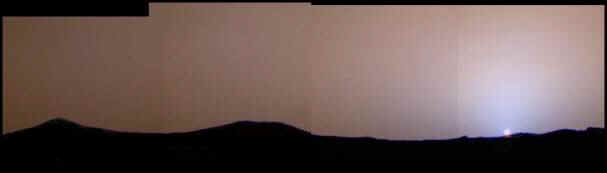

La règle à calcul analogique inventée en 1622 a été remplacée par la calculette numérique en 1975, le disque 33 tours analogique par le compact disc numérique en 1982. En juillet 1997, les images de la sonde martienne Pathfinder, prises et transmises par des systèmes numériques, ont été publiées directement par la NASA sur Internet. Des millions de personnes en ont pris connaissance sans aucun intermédiaire analogique dans toute la chaîne depuis Mars.

Figure 3 : Coucher de soleil sur Mars

http://nssdc.gsfc.nasa.gov/planetary/image/marspath_ss24_1.jpg

En 1998, il s'est vendu, pour la première fois dans le Monde, plus de téléphones mobiles où le son est numérisé de bout en bout que de téléphones fixes analogiques. La télévision numérique qui s'impose actuellement sur le câble et le satellite, a fait ses débuts en diffusion terrestre en novembre 1998 aux Etats-Unis. Les Américains visent un arrêt total des émissions analogiques en 2006. Avec l'appareil photo numérique grand public dont 180 000 exemplaires seront vendus en France en 1999, le dernier média analogique va disparaître. Cette transformation radicale a été provoquée par les progrès dans les technologies de compression et des systèmes de stockage qui ont permis de construire des systèmes numériques de plus en plus puissants à des coûts raisonnables. L'évolution de la technologie des mémoires de masse est donc aussi déterminante que celle des unités centrales.

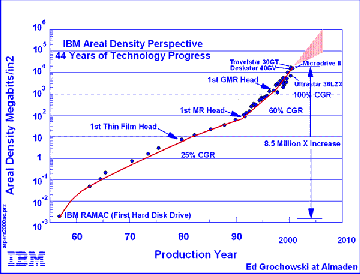

Sur les supports magnétiques, le coût du stockage de 1 000 caractères est passé de 15 000 francs en 1955, à 10 francs en 1980 puis à 0.1 centime en 1995 et à 0,001 centime en 2000. Comme pour la technologie des composants, la technologie de stockage des informations sous forme magnétique a fait des progrès fantastiques. L'ingénieur danois Valdemar Paulsen a présenté le premier enregistrement magnétique à l'exposition universelle de Paris en 1900. Depuis cette date, la corde à piano a été remplacée par des matériaux magnétiques enduits sur des bandes de plastiques ou des disques rigides, mais le principe de l'enregistrement des données est resté le même que dans l'appareil de Paulsen. Un courant électrique peut magnétiser une petite zone de matériau magnétique, ce qui enregistre les données.

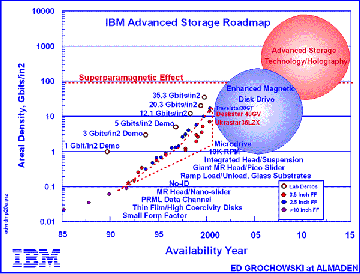

Figure 4 : L'évolution de la densité du stockage

Source IBM

La densité des enregistrements magnétique atteint le milliard de caractères par cm2. Comme pour les transistors, la diminution de la taille des zones magnétiques améliore non seulement la densité mais aussi la vitesse de lecture des données. A vitesse de lecture constante, le nombre de données lues est plus grand. En revanche, la diminution de la taille des zones magnétiques diminue l'intensité du champ magnétique à lire. L'inventon des têtes de lecture magnétorésistives au début des années 90 a accéléré la vitesse des progrès. La densité de stockage double tous les 9 mois. Un bit n'occupe qu'une surface de 0.7 micron par 0.06 micron. La densité devient supérieure à celle des mémoires RAM. Le coût du stockage sur disque magnétique devient inférieur à celui du stockage sur papier ! Les limites de l'enregistrement magnétique seront bientôt atteintes, sans doute vers 2005. La densité maximum semble être aux alentours de 15 Giga bits par cm2.

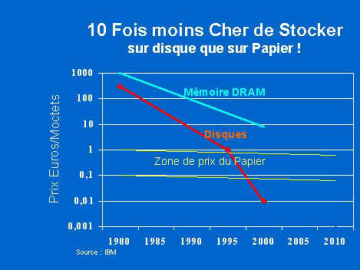

Figure 5 : L'évolution du prix du stockage

Source IBM

Heureusement, une autre technologie prend le relais. C'est l'enregistrement optique. L'énergie nécessaire à la lecture n'est plus stockée dans le support. Un rayon laser extérieur lit les données repoussant ainsi les limites de la taille des informations stockées. Cette technologie a été utilisée pour le compact disc audio introduit en 1983. Il a connu tout de suite un très grand succès et le disque analogique en vinyle a disparu en quelques années. Le son est numérisé et le compact disc enregistre donc une succession de bits. La capacité de ce support est de 650 millions de caractères. Ce compact disc a été rapidement utilisé dans le monde de l'informatique sous le nom de CD-ROM par analogie avec les ROM (Read Only Memory ) car il n'était pas réinscriptible. Depuis on a produit des CD-R enregistrables et des CD-RW que l'on peut enregistrer et effacer un millier de fois. Le premier graveur de CD-ROM utilisé par l'industrie du disque coûtait un million de dollars. La diffusion massive de cette technologie dans le monde du PC a fait chuter le prix du graveur à moins de 1000 F, et il fonctionne 12 fois plus vite. Les sons, les images et surtout la vidéo numérique nécessitent des capacités beaucoup plus importantes. Les principaux fabricants mondiaux se sont mis d';accord fin 1995 sur le standard DVD qui permet de stocker 4.7 milliards de caractères par face soit une capacité dix fois supérieure à celle du CD-ROM pour la même surface.

Figure 6 : Prévision d'évolution

Source IBM

De nombreuses recherches sont entreprises sur le stockage holographique qui devrait permettre de repousser les limites des densités de stockage par un facteur 100.

3. Des réseaux spécialisés à l'Internet

Les réseaux ont toujours été des sources de progrès et d'innovation comme les routes et les aqueducs de l'empire romain ou les chemins de fer du XIXème siècle. Les réseaux téléphoniques, de télédiffusion ou de satellites du XXème siècle ont permis de nous affranchir des contraintes de l'espace et du temps.

L'essor des télécommunications

Il n'y a pas si longtemps, le téléphone était le seul moyen de communication entre les personnes. Depuis le début des années 70, les ordinateurs aussi échangent des données entre eux ou avec des terminaux. Les 7 millions de Minitel en France puis les centaines de millions de micro-ordinateurs dans le monde qui utilisent les millions de serveurs connectés à l'Internet ont provoqué une explosion des besoins en télécommunications. Les échanges de données entre ordinateurs nécessitent des capacités et des vitesses de transmission beaucoup plus élevées que pour le téléphone. Il faut donc augmenter considérablement les capacités des réseaux de télécommunications.

Après l'invention fondamentale du transistor en 1948, l'invention du Laser a eu lieu en 1958. En utilisant Laser et fibres optiques, les électrons sont remplacés par les photons pour transporter les bits d'information. Les progrès ont été très rapides et les fibres optiques ont rapidement supplanté le cuivre comme technologie des télécommunications. Le dernier câble transatlantique métallique posé en 1975 permettait l'établissement de 10 000 communications simultanées. Le premier câble transatlantique à fibre optiques posé en 1988 a une capacité de 40000 communications simultanées. Le développement de la technologie des fibres optiques est très rapide. De 4 500 ans avant J.-C. aux années 60, la transparence du verre avait été améliorée dans un rapport 10 000. Depuis un autre rapport 10 000 a été gagné. Une fenêtre épaisse de 10km, réalisée dans la meilleure fibre optique serait plus transparente qu'une fenêtre de verre traditionnel de 1cm d'épaisseur. Aujourd'hui, la performance des réseaux à fibres optiques double tous les 12 mois à comparer au doublement tous les 18 mois de la puissance des micro-processeurs.

Quelle est la réserve de progression pour la technologie optique ? La technologie actuelle peut encore progresser d'un facteur supérieur à 1000. Il faudra sans doute 20 ans pour y arriver, ce qui donne des possibilités d'amélioration considérable des capacités et des débits jusqu'en 2020. En particulier, il devrait être possible de traverser l'Atlantique en fibre optique sans répéteur.

Internet change la donne

Cependant, le développement des technologies numériques est en train de changer complètement les règles du jeu. Les réseaux spécialisés, optimisés pour un seul média, sont remplacés par une infrastructure unique réduite à son rôle le plus élémentair : la connectivité. Fondée sur les technologies de l'Informatique et les standards de l'Internet, cette infrastructure permet maintenant de tout connecter à tout, partout. Cette infrastructure mondiale unique qui se met en place autour des réseaux de calculateurs reliés par l'Internet aura sans doute une plus grande influence sur notre société que celle de tous les réseaux précédents.

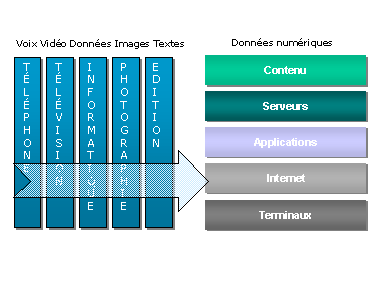

Figure 7 : Des réseaux spécialisés vers l'infrastructure unique

Autrefois, chaque média avait construit son infrastructure spécialisée. Pour fournir un service de téléphone, il fallait d'abord faire des investissements considérables dans un réseau dédié et dans des équipements terminaux. Pour développer la télévision, il avait été nécessaire de tout standardiser depuis les caméras jusqu'aux récepteurs de télévision. Ces deux réseaux avaient été en leur temps des réussites techniques exemplaires. Cependant, l'interdépendance de tous les éléments rend les évolutions très difficiles et très lentes. Le passage du téléphone au numérique (Numéris) a été un échec commercial car il était nécessaire de changer les équipements terminaux pour un avantage minime. L'évolution de la télévision vers la couleur ou le son stéréo a été lente et complexe pour rester compatible avec les équipements installés. De surcroît, les opérateurs qui contrôlaient l'infrastructure n'avaient aucune incitation à suivre la baisse des coûts des équipements. Par exemple, la réduction considérable des coûts des calculateurs (le rapport est de l'ordre de 1 à plusieurs millions !) ne s'est pas vraiment traduite dans la baisse des prix des communications téléphoniques. Un service comme l'accès au numéro de l'appelant est facturé alors qu'il ne coûte strictement rien. En fait, l'intégration verticale et l'interdépendance entre toutes les couches permet aux fournisseurs de facturer un coût global incluant le coût de la communication et celui des services fournis.

Le remplacement des terminaux simples par des PC puissants a permis de déployer la technologie Internet. Internet réduit le réseau à sa fonction de base : assurer la connexion entre deux équipements. En revanche, il ne fournit aucun des services assurés traditionnellement par les opérateurs de télécommunications comme l'acheminement correct des informations ou une garantie de débit. Chaque élément d'un réseau Internet a le droit d'éliminer les informations qui circulent en cas d'incident ou de surcharge. Ce sont les logiciels des machines connectées qui font leur affaire de s'adapter au débit disponible, de renvoyer si nécessaire les informations perdues et bien sûr de s'adapter au type de contenu. Cette simplification du réseau a un prix : il faut une puissance de calcul d'environ un million d'instructions par seconde à chaque extrémité. Il y a dix ans, seules les stations de travail haut de gamme supportaient cette pénalisation. Aujourd'hui, le PC bas de gamme exécute plusieurs centaines de millions d'instructions par seconde rendant ainsi économique l'usage de cette technologie.

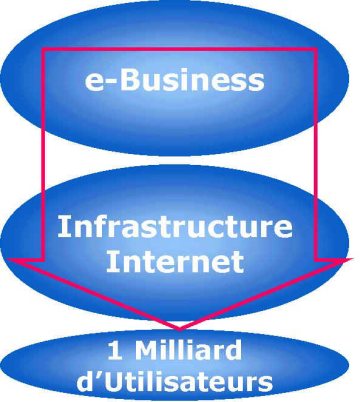

Figure 8 : Le modèle e-business

L'infrastructure Internet change donc la donne. Elle permet d'éliminer les interdépendances en séparant l'infrastructure de communication et les applications qui l'utilisent. Il se crée ainsi deux marchés mondiaux très concurrentiels: celui qui fournit la connectivité mondiale et celui des contenus et des services. Cette nouvelle concurrence a déjà permis de réduire le coût de la connectivité par un facteur de 1 à plusieurs milliers. Avec un accès par le Câble ou l'ADSL, un particulier est connecté en permanence à grande vitesse sur Internet pour 300 Francs par mois. Mais surtout, cette nouvelle infrastructure favorise l'innovation. Les nouvelles applications ou les nouveaux services peuvent bénéficier sans investissement d'une connectivité mondiale vers bientôt un milliard de clients potentiels à un coût dérisoire

Vers le milliard d'utilisateurs en ligne

Environ 300 millions de personnes sont d'ores et déjà en ligne sur Internet et ce nombre dépassera sans doute le milliard en 2005. Ce marché d'un milliard d'utilisateurs accessible quasi gratuitement au travers d'une simple liaison Internet devient l'enjeu de la ruée vers l'or du 21ème siècle : la bataille des parts de marché dans la nouvelle économie autour des domaines clés que sont les portails d'accès, les services financiers ou la vente au détail. Les valorisations boursières atteintes donnent une idée des espoirs suscités.

Moins visible mais beaucoup plus important pour l'évolution de l'Informatique, ce milliard d'utilisateurs va peser sur l'architecture des applications informatiques des entreprises. Toutes les innovations technologiques et tous les nouveaux développements seront passés au crible de ce milliard de clients, expérimentateurs ou développeurs. Un processus de sélection «Darwinien» remplace les décisions de comités souvent biaisées par la politique ou l'incompétence. Cette formidable coopération mondiale informelle a déjà produit les meilleurs logiciels, ceux qui font tourner l'Internet, imposé ses choix comme le MP3 pour la diffusion de la musique et va peut être réussir à fédérer sous la bannière LINUX tous les UNIX propriétaires. Le temps où un fournisseur pouvait protéger son «empire» par des normes propriétaires est désormais révolu.

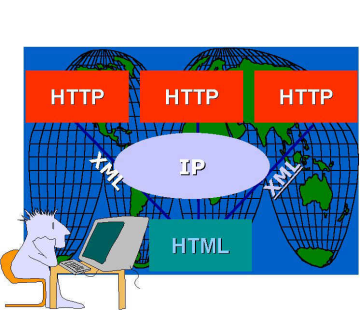

Une nouvelle architecture pour les applications informatiques des entreprises

la diffusion d'Internet en 5 ans auprès de 300 millions d'utilisateurs est une preuve concrète de l'efficacité de cette technologie : Internet s'est déployé beaucoup plus rapidement que la radio, la télévision ou le téléphone mobile. La mise en place d'une infrastructure Internet dans l'entreprise est donc un préalable pour bénéficier rapidement des avantages, que ce soit pour la communication avec l'extérieur (Courrier électronique ou serveur Web), pour la gestion interne de l'entreprise, la gestion des connaissances ou pour la relation avec les clients et les fournisseurs. Cette infrastructure comporte non seulement un réseau IP (Internet Protocol) mais encore l'accès aux applications en mode HTTP (HyperText Transfer Protocol) sous un navigateur HTML (HyperText Markup language) et échangeant des données en XML. Les avantages pour l'entreprise sont immédiats : une infrastructure unique pour toutes les applications informatiques et multimédia, un poste de travail banalisé indépendant des systèmes centraux et des serveurs locaux et un déploiement technique instantané des nouvelles applications.

Figure 9 : L'architecture Internet

La révolution Multimédia bouscule les acteurs en place. A la lumière de ces évolutions techniques, il est facile de prévoir que la maîtrise de l'infrastructure Internet et la maîtrise des contenus et des services seront les enjeux de la prochaine décennie. Cette maîtrise nécessite de changer profondément la manière de communiquer, de gérer l'information, de faire du commerce, de travailler et de concevoir et réaliser des produits. Le risque est grand de continuer à faire du vieux avec du neuf. En évitant les biais des réseaux précédents optimisés autour d'un contenu, Internet a créé une place de marché pour des concepts nouveaux qui tirent parti de la connectivité abondante et peu coûteuse. Cette infrastructure est une frontière clé entre un média de communication et les applications construites sur ce média. C'est une frontière très spéciale, puisqu'elle permet à ces deux marchés de fonctionner selon leurs propres règles. Avec les nouvelles technologies numériques, l'avantage s'est déplacé vers une conception souple qui permet de tirer rapidement parti d'opportunités non prévues.

4. De la programmation à l'assemblage d'objets et de composants logiciels.

Les progrès de la miniaturisation fixent le rythme d'évolution de la technologie du matériel mais c'est la vitesse de déploiement du logiciel qui est déterminante pour la pénétration des ordinateurs dans toutes les activités industrielles ou intellectuelles. Le logiciel transforme l'ordinateur d'un outil qui peut théoriquement résoudre un problème en un outil qui le résout en pratique. Le matériel est au logiciel ce que les instruments sont à la musique. Léonard De Vinci définissait la musique comme le «modelage de l'invisible». Cette définition est encore plus adaptée à la description du logiciel.

Si les progrès ont été foudroyants dans le domaine du matériel, ils ont été tout aussi impressionnant dans le domaine du logiciel. 15 ans après la définition de l'architecture des machines par Von Neuman en 1945, presque tout avait été inventé et les programmeurs attendaient déjà des machines plus puissantes pour progresser. Il suffit pour s'en convaincre de se souvenir des dates d'apparition des langages : FORTRAN né en 1957, LISP en 1959, COBOL en 1960 et BASIC en 1964. Il en est de même pour les systèmes d'exploitation. Les fonctions offertes à un programme développé en 1966 sous l'O.S. des IBM 360 étaient pratiquement les mêmes que celles disponibles aujourd'hui sous la toute dernière version OS/390. La première version d'UNIX a été développée à partir de 1969 et les bases de données relationnelles sont nées en 1970.

Les premiers programmes d'ordinateurs avaient été fabriqués par des mathématiciens et des scientifiques qui pensaient que le travail était simple et logique. Le logiciel s'est révélé plus difficile à développer qu'ils ne l'avaient supposé. Les ordinateurs étaient têtus. Ils s'obstinaient à faire ce qui était écrit plutôt que ce qui était voulu. Le résultat fut qu'une nouvelle race d'artisans prit le relais pour faire le travail. Ils n'étaient souvent ni mathématiciens, ni scientifiques mais ils étaient profondément engagés dans une aventure avec les ordinateurs, une aventure précurseur d'une nouvelle science.

L'évolution des langages de programmation

L'idée des langages de programmation est aussi vieille que celle du calculateur digital. Il suffit de programmer un ordinateur directement en code binaire pour comprendre immédiatement pourquoi. Les premiers programmeurs ont donc rapidement inventé des notations symboliques appelées «langage» traduites en code binaire par un programmes appelé «compilateur». Parmi les premiers langages, celui dont l'influence a été la plus grande est sans nul doute le FORTRAN développé entre 1954 et 1957 par John Backus et ses collègues chez IBM. Il n'était pas sûr qu'à une époque où la puissance des machines était très limitée, un compilateur puisse produire du code efficace. Cet objectif avait été atteint et FORTRAN est encore utilisé aujourd'hui. Cependant, la version originale de FORTRAN comportait des contraintes inutiles, des structures de données limitées et surtout de sérieuses déficiences dans le contrôle de la logique du programme. Dans un certain sens, on peut dire que toutes les recherches dans la définition de nouveaux langages de programmation ont été motivées par des essais de correction des défauts du FORTRAN.

Que les langages aient été définis par un Comité comme COBOL, une organisation commerciale comme PL/I, un individu comme PASCAL ou par le Ministère de la Défense américain comme ADA, toutes les tentatives de définir le langage universel ont échoué, laissant la voie libre à des milliers de langages dont seulement une petite dizaine est largement répandue.

Contrairement au matériel, les progrès dans le logiciel ne viennent pas d'une seule technologie ou même d'une technologie dominante. Par exemple dans le domaine des langages, les progrès proviennent de meilleure structures de contrôle de programmes, de meilleurs environnements de programmation, d'outils de programmation plus puissants. L'évolution semble lente, mais il y a progrès. Après quelques années, ces progrès ne sont plus perçus comme des améliorations mais comme des nouveautés. Mais ce qui est surprenant, c'est que les vieilles techniques ne disparaissent pas. Certains continuent de programmer dans des langages qui datent de 30 ans comme FORTRAN ou même en écriture ancienne connue sous le nom d'assembleur alors que d'autres considèrent ces outils comme des fossiles vivants. Charles Quint disait « je parle en espagnol à Dieu, en italien aux femmes, en français aux hommes et en allemand à mon cheval ». Pour les hommes comme pour les machines, il n'y a pas de langage idéal.

L'approche orientée objet

Dans les langages procéduraux (FORTRAN, COBOL,...), les instructions du langage sont impératives et s'adressent à une entité qui n'est pas désignée tout simplement parce qu'il n'y a qu'une seule possibilité : c'est l'ordinateur considéré comme un tout. Dans les langages orientés objets, l'ordinateur est virtuellement divisé en objets qui peuvent être adressés individuellement. Ces objets peuvent communiquer entre eux en envoyant des messages. Cette approche a été introduite pour la première fois par Ole-Johan Dahl et Kristen Nygaard dans Simula 67, un langage dérivé d'Algol 60. L'idée n'a pas suscité beaucoup d'intérêt jusqu'au développement de Smalltalk en 1970 par Alan Kay et ses collègues du Xerox Palo Alto Research Center. Cette approche s'est répandue progressivement dans les années 80 (Objective C, C++), au fur et à mesure que les performances des ordinateurs masquaient l'inévitable inefficacité du code.

Avec les langages procéduraux classiques, le logiciel est produit en enchaînant des procédures qui contiennent des types de données et des algorithmes. La programmation orientée objet généralise la notion de type, combine algorithmes et données en objets et supprime la décomposition fonctionnelle des langages procéduraux. Cette décomposition est remplacée par l'héritage, le polymorphisme et l'échange de messages. L'héritage permet de définir de nouveaux objets à partir d'objets existants. Le polymorphisme permet de définir des actions indépendantes des caractéristiques d'un objet particulier: IMPRIMER, par exemple peut être valide aussi bien pour du texte que pour des images, vers une imprimante noir et blanc ou couleur. A la place de gros blocs de programmes contenant des clauses « if-then-else », un programme orienté objet contient des fonctions polymorphes qui résolvent les « if-then-else » pendant l'exécution. Cette souplesse explique d'ailleurs la relative inefficacité de ces langages.

Toutefois, l'héritage et le polymorphisme sont aussi complexes et sujets à erreurs que la décomposition fonctionnelle traditionnelle. Ainsi l'approche orientée objet n'apporte guère de gains en terme de productivité des programmeurs. En revanche, cette approche a d'autres mérites : en particulier elle introduit la notion de réutilisation. Avec la réutilisation, l'ère des grands projets informatiques qui repartent de zéro est révolue. Des objets seront développés par des artisans du logiciel qui les fourniront aux réalisateurs de systèmes plus importants.

Les outils de développement visuels

Tous les outils de développement visuels, depuis les interfaces graphiques jusqu'aux générateurs de programmes, permettent des accroissements de la productivité dans un rapport qui peut aller de 1 à 5. Ces outils avaient été initialement dédaignés par les «vrais programmeurs», adeptes de C ou de C++. Mais grâce aux accroissements de productivité et à une plus grande facilité de création ou de modification, les programmeurs «à la souris» gagnent du terrain si l'on en juge par la percée d'outils comme Visual Studio de Microsoft ou Visual Edge d'IBM. Les outils de base du programmeur moderne s'appuient sur des ateliers visuels, des techniques objets et des bibliothèques de composants.

Vers l'assemblage de composants

Les espoirs engendrés depuis 10 ans par les technologies «Orientées Objets» avaient tardé à se matérialiser. Le principe de l'objet est de dissocier la réalisation des objets de leur utilisation. Ce principe est encore plus intéressant pour la réalisation des applications si on se borne à assembler des objets existants. Jusqu'à présent les infrastructures propriétaires fragmentaient le marché des objets. En outre, comme il n'y avait pas de langage commun pour la représentation des données, les objets manipulant des données étaient peu réutilisables. Dans ce domaine aussi, Internet change la donne : il existe maintenant une architecture unique pour les applications -HTTP-IP-XHTML- et un métalangage pour les données -XML-. Le marché des objets va donc se développer très rapidement et la part programmation dans la réalisation des systèmes va considérablement diminuer.

5. Un dialogue naturel avec les machines ?

Un programme transforme l'ordinateur en un outil adapté à un usage particulier, que cet usage soit la fabrication d'un avion ou l'écriture d'un document. L'interface utilisateur, c'est la partie du logiciel qui sert d'intermédiaire entre l'utilisateur et le programme. Autrefois l'interface utilisateur était la dernière partie à être conçue. Maintenant, c'est devenu la première. En effet, pour le débutant comme pour l'utilisateur expérimenté, ce qu'il perçoit devient «son» ordinateur. Cette illusion est la métaphore simplifiée que chacun construit pour expliquer les actions du système ou pour provoquer de nouvelles actions. Il faut noter les travaux fondamentaux réalisés dès 1973 par les équipes du Xerox Palo Alto Research Center (XPARC) avec l'invention de la souris et des fenêtres qui ont donné naissance aux premiers produits commerciaux comme le STAR en 1978 ou la LISA en 1982. Coûteux et peu performants, ces produits ont été des échecs. En 1985, le Mac d'Apple a été le premier produit à réussir commercialement suivi en 1990 par Windows 3.0 de Microsoft dans le monde du PC.

La plupart des principes et des périphériques développés pour améliorer cette métaphore sont maintenant devenus très courants dans la conception des logiciels. Le principe le plus important a été le WYSIWYG («What You See Is What You Get») : l'image sur l'écran est toujours une représentation fidèle de la métaphore de l'utilisateur. Chaque manipulation de cette image entraîne une modification prévisible de l'état du système ou tout au moins tel que l'utilisateur l'imagine. Les éléments de cette métaphore qui se sont imposés actuellement sont les fenêtres (Windows), les menus, les icônes et un outil de pointage. Les fenêtres rendent possible la représentation simultanée sur l'écran de plusieurs activités. Les menus permettent de choisir les prochaines actions. Les icônes représentent des objets informatiques sous forme concrète. L'outil de pointage, généralement la souris, permet de sélectionner les fenêtres, menus et icônes.

Tout cela a donné naissance à une nouvelle génération de logiciels interactifs, à base de métaphores, qui utilisent cette réalité virtuelle pour simplifier la tâche de l'utilisateur et pour démultiplier ses capacités à simuler le fonctionnement du programme sans avoir à faire appel à des abstractions ou à des programmes cachés. Le concepteur de logiciel doit contrôler le contexte théâtral qui sert à créer l'illusion de la réalité pour améliorer la simplicité d'emploi pour l'utilisateur.

Le navigateur Internet

Le navigateur Internet devient l'interface universelle entre l'homme et la machine. D'un point de vue technique, le navigateur traduit le langage HTML et les données XML en une présentation qui tient compte des capacités de l'équipement et de l'utilisateur. Entre un téléphone mobile et une station de travail, il faut s'accommoder d'un rapport de 1 à 100 entre la taille des écrans, la puissance des machines et les performances des réseaux . Il faut aussi s'accommoder d'une grande disparité entre les utilisateurs qui vont du débutant à l'expert ou qui peuvent souffrir de handicaps moteurs visuels ou auditifs. Mais au-delà de cette indépendance par rapport aux équipements, c'est la simplicité du «pointer/cliquer» de l'hypertexte et la convivialité des documents multimédia qui expliquent le succès de cette technologie.

- Le "pointer/cliquer" de l'hypertexte a été rendu possible par 2 percées décisives: L'adressage unique universel des documents grâce aux URI/URLs (Uniform Ressource Identifier ou Locator) qui permettent de pointer d'un seul clic sur n'importe quel document à l'intérieur d'un serveur sans s'y connecter au préalable et sans contrôle a priori de validité. Sans le célèbre "HTTP 404 document non trouvé", la gestion des documents aurait été impossible. Le succès de ce "pointer/cliquer" pousse les concepteurs au but ultime : tout obtenir en un clic! Amazon.com a même essayé, sans succès, de "breveter" sa méthode d'achat en ligne en un seul clic

- La convivialité du multimédia avec images, sons et vidéos intégrés dans le navigateur simplifie la tâche de l'utilisateur qui n'a plus à se préoccuper de la nature du contenu du document.

L'accès aux applications par un navigateur engendrent de nombreux avantages

qui expliquent le déploiement rapide de l'Internet :

- l'élimination des

longues et coûteuses installations de logiciels sur les postes de travail. Les

mises à jour ou les logiciels nécessaires sont automatiquement téléchargés sans

action particulière de l'utilisateur.

-l'accès universel depuis un poste de

travail banalisé à toutes les applications indépendamment des systèmes utilisés.

Ce découplage entre le poste client et le système serveur permet à chacun

d'évoluer séparément.

La personnalisation

La personnalisation permet à l'utilisateur d'un système de conserver ses informations personnelles et de sélectionner ce qu'il veut voir dans l'ordre qui lui plait. Cette personnalisation, souvent dénommée My.. est offerte par tous les grands portails d'accès à Internet comme My Yahoo! crée en 1996. Habitués à des pages statiques, peu d'utilisateurs tirent réellement partie des nouvelles possibilités offertes. La personnalisation apporte un autre avantage : l'accès aux données personnelles à partir de n'importe quel équipement, que ce soit un PC au bureau, à la maison ou en voyage. Cette fonction devrait en augmenter l'attrait. Naturellement le fait de conserver des informations personnelles sur une base de données centrale augmente le besoin de sécurité.

Créer la confiance par la sécurité

Quand Jules César envoyait ses instructions à ses généraux, il n'avait confiance ni dans la sécurité du réseau de voies romaines ni dans les messagers. Il chiffrait donc ses messages par une méthode de substitution de lettres. Comme les voies romaines, le réseau Internet assure la connectivité, pas la sécurité. Sécuriser les données, c'est garantir l'authentification réciproque des correspondants pour être sûr de son interlocuteur, l'intégrité des données transmises pour être sûr qu'elles n';ont pas été modifiées accidentellement ou intentionnellement. Il est parfois nécessaire de garantir aussi la confidentialité pour éviter que les données soient lues par des systèmes ou des personnes non autorisées. Avec les infrastructures à clés publiques et les techniques de certificats, tous les composants techniques existent aujourd'hui pour garantir une sécurité qui dérange les gouvernements. Cependant, le principal obstacle à la diffusion rapide de ces technologies est la mentalité «ligne Maginot» héritée des anciens systèmes propriétaires et symbolisée par la mise en place de pare-feux aussi coûteux qu'inefficaces. Les utilisateurs aussi n'ont pas encore acquis les réflexes "sécurité" nécessaires. Ils ferment leur voiture à clé alors qu'elle n';est accessible qu'à quelques milliers de personnes mais laissent leur PC ouvert sur Internet à des centaines de millions d'inconnus.

L'âge de l'information

Depuis longtemps, on en rêvait. L'augmentation régulière de la puissance des microprocesseurs, les progrès des développements du logiciel avec les techniques graphiques et orientées objets, la numérisation du son puis des images et les techniques de compression des signaux, le déploiement des réseaux accéléré par les fibres optiques et les satellites dessinaient les contours d'un nouveau paysage : la Société de l'information. Cette société sera construite autour de voies électroniques ou réseaux chargés d'acheminer dans les maisons, les entreprises, les universités, les administrations, les écoles ou les hôpitaux une palette de services interactifs : messagerie, visiophonie, téléenseignement, consultation de banques de données, téléachat, télévision à la demande, médecine assistée à distance... bouleversant de manière radicale la vie des gens et des entreprises.

Les nouvelles technologies de l'information représentent aussi un bouleversement culturel des modes d'éducation et de communication dont les héritiers sont les enfants d'aujourd'hui. Accéder à des informations par l'intermédiaire d';un écran et d'un clavier est pour la jeune génération -la génération Nitendo- une deuxième nature alors que cette manipulation semble souvent difficile aux adultes. En matière d'éducation, les élèves utilisent de plus en plus souvent l'ordinateur comme un véritable assistant pédagogique qui leur permet de cultiver leurs connaissances à leur propre rythme dans toutes les disciplines.

Avec le multimédia se prépare sans doute la remise en cause de la communication écrite telle que nous la concevons depuis Gutenberg. Le terme n'est pas si loin où les lecteurs devront apprendre à naviguer dans un monde d'images et de textes, le simple « clic » sur un mot ou une image permettant un accès quasi instantané à toute information stockée dans l'un des ordinateurs de la Planète. Enfin, le développement des réseaux du futur va changer le fonctionnement même de la société, modifiant par exemple l'organisation du travail, l'accès des citoyens aux services de santé ou d'éducation, les relations administration/administré, voire les conditions d'exercice de la démocratie.

L'histoire enseigne que le progrès se propage par vagues. Il est donc raisonnable d'affirmer que la société du XXIème siècle sera façonnée par les technologies de l'information. La large disponibilité d'ordinateurs à un nombre croissant d'utilisateurs augmentera la créativité qui sera génératrice de nouveaux progrès. Les ordinateurs actuels ne peuvent améliorer que des capacités mentales simples et relativement routinières mais un progrès continu est fait vers l'amélioration des capacités d'analyse et d'inférence. De même que les machines capables d'améliorer les capacités physiques de l'homme ont créé la révolution industrielle, de même les ordinateurs par leur faculté d'étendre les capacités mentales de l'homme, sont le moteur de l'actuelle et improprement nommée révolution informatique. L'Odyssée informatique vient tout juste de commencer.

Références bibliographiques

[1] LEWIS (T).- The Next 10000 Years, Computers (1996).

[2] MAYO (J.S.) . - Materials for Information and Communication. Scientific American (1986).

[3] KAY (A). - Computer Software. Scientific American (1984).

[4] TESLER (L.G.). - Programming Languages. Scientific American (1984).